Diagonalizable (대각화)

Sqaure Matrix가 $n$개의 eigenvalue를 가지고 (multiplicity를 감안하여 중복 카운트. 0인 Eigenvalue도 카운트),

이들 각각의 eigenvalue들이 각자의 multiplicity에 해당하는 dimension을 가지는 eigenspace를 가지고 있는 경우 가능.

- 항상 각기 다른 eigenvalue의 Eigen Space들은 서로 linearly independent함 (orthogonal까지 보장하는 건 아님!).

- 때문에, eigenvalue가 자신의 multiplicity(중복도)에 해당하는 dimension의 eigen space를 가진다면, $n\times n$ square matrix는 $n$개의 linearly independent한 eigenvector를 가짐:

- 이를 Algebraic Mulitiplicity = Geometric Multiplicity 라고 표현

- $A$ 가 singular matrix(정칙행렬, regular matrix가 아닌 경우)여도 Diagonalizable이 가능할 수 있음:

singular matrix 인 경우 0인 eigenvalue가 존재함.- 주의할 점은 "0이 아닌 eigenvalue의 갯수"가 rank를 의미하는 것은 아님.

- SVD에서의 singular value의 경우, 0이 아닌 singular value의 수는 rank와 같음.

- 즉, Eigenvalue는 0일 수 있음: Matrix의 eigenvectors가 linearly independent이기만 하면 Diagonalizable.

쉽게 애기해서,

Square Matrix가 자신의 행(or 열)의 수에 해당하는

Linearly Independent Eigenvector를 가질 경우

Diagonalizable.

Diagonalizable은 "다음을 만족하는 invertible한 matrix $\mathbf{P}$와 diagonal matrix $\mathbf{D}$를 얻을 수 있음"을 의미.

$$

\mathbf{A} = \mathbf{PDP}^{-1}

$$

where

- $\mathbf{D}$는 eigenvalue들을 main diagonal에 놓임.

- $\mathbf{P}$는 $\mathbf{D}$의 eignevalue에 해당하는 위치의 column에 해당하는 eigenvector들이 놓인 invertible matrix임.

충분한 수의 Linearly Independent한 eigenvector들을 가지는 Square Matrix $\mathbf{A}$는

diagonlizable하며,

이는 diagonal matrix $\mathbf{D}$와 $\mathbf{A}$가 similar임을 의미함: Similarity .

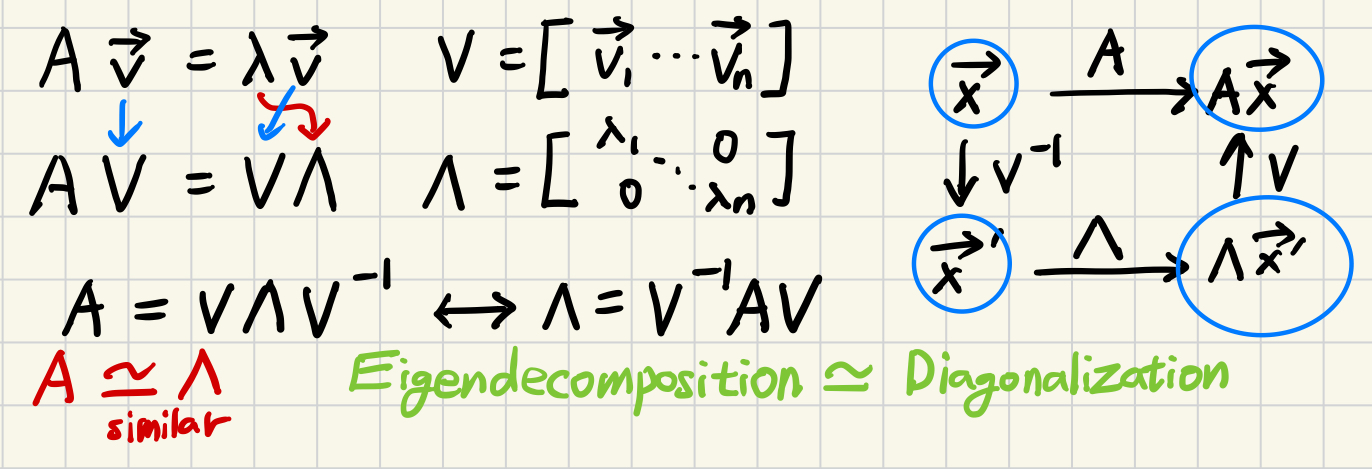

Diagonalization은 Eigen Decomposition 보다 조금 더 큰 개념처럼 정의가 되나,

실제로 둘은 하나가 성립하면 다른 쪽도 성립하는 관계임:

Diagonalizable Matrix는 항상 Eigen Decomposition이 가능하고, 이 역도 성립함.

Invertible과 Diagonalizable은 직접적인 관계가 없음

주의할 것은, 자신의 "열의 수와 같은 Linearly Independent한 column vector를 가지고 있다"고 해도 "이들 모두가 eigenvector임을 보장하는 것은 아니므로 Diagonalizable 한 것은 아님::

- 즉, Invertible Matrix가 반드시 Diagonalizable이라고 말할 수 없음.

- 또한, Diagonalizable이라고 해도 반드시 Invertible 은 아님: Eigenvalue가 0일 수 있음.

Eigen Decomposition

Eigen-Decompoistion은 다음으로 표기됨.

- $V$: Eigenvector Matrix (보통 unit vector로 처리됨)

- $\Lambda$: Eigenvalue Matrix (Diagonal Matrix이며, 값이 큰 수가 작은 열에 놓이는 Descending Order가 일반적)

Orthogonal Diagonalizable (직교대각화 가능) - Symmetric Matrix

$\mathbf{A}$가 real symmetric matrix (real matrix인 경우임. 복소수로 확장시 hermitian matrix)인 경우로,

$\mathbf{P}$가 단순히 invertible을 넘어 orthogonal matrix (Hermitian matrix의 경우 unitary matrix)가 됨.

(이후 real matrix를 가정함)

$\mathbf{A}$가 다음을 만족시 Orthogonal Diagonalizable이라고 함 (복소수인 경우 Unitary Diagonalizable).

$$\mathbf{A}=\mathbf{PDP}^\top$$

where

- $\mathbf{P}$는 diagonlizable에서는 non-singular이기만 하면 되지만,

- orthogoanl diagonlizable하려면 $\mathbf{P}^{-1}=\mathbf{P}^\top$인 orthogonal matrix가 되어야 함.

- $\mathbf{P}$는 column으로 orthonormal한 eigenvector들을 가짐.

(symmetric인 경우에만 해당 하고, 일반적으로 eigenvector들은 linearly independent만 성립함)- 즉, linearly independent eigenvectors를 가진다고 해도,

- 이들이 orthogonal이지 않을 수 있음.

- 즉, Diagonlizable (~Eigen Decomposition)이 Orthogonal Diagonalizable을 보장하진 않음.

- Symmetric Matrix에서는 eigenvalue들이 항상 실수 이고, eigenvector들이 mutually orthogonal임.

- $\mathbf{P}$는 column으로 orthonormal한 eigenvector들을 가짐.

- $\mathbf{D}$는 $\mathbf{A}$의 eigenvalue들을 main diagonal로 가짐.

- 즉, $n\times n$ square matrix $\mathbf{A}$는 orthonormal인 eigenvector들을 $n$개 가지고 있음을 의미함.

- 달리 말하면, mutliplicity에 해당하는 dimension의 eigenspace가 있어야 하며, 각각의 eigenspace들 서로 orthogonal하다는 애기임.

일반적으로 특정 square matrix가 diagonlizable인지 여부는 확인을 해봐야 아는 것과 달리,

symmetric matrix $\mathbf{A}^\top=\mathbf{A}$인 경우 (complex matrix의 경우 Hermitian matrix,$\mathbf{A}^H=\mathbf{A}$)에는

항상 orthogonal diagonalization이 가능함.

Orthogonal Diagonalization은

- Eigen Decomposition ($PDP^{-1}$)의 Special Case로서,

- square matrix 를 대상으로하는 Eigen Decomposition 중에서

- symmetric matrix 만으로 대상을 좁히고 있음: Eigen Decomposition에선 eigenvalue가 complex number일 수도 있음.

Symmetric Matrix는

항상 Multiplicity 포함하면 행(=열)의 갯수의 real eigenvalues (음수 가능)를 가지며,

distinct eigenvalue에 대응하는 eigenvector들(정확히는 eigenspace)은 서로 orthogonal 이고

multiplicity 의 수에 해당하는 orthogonal eigen vector가 존재하기 때문에

항상 Orthogonal Diagonalizable임.

invetible (=non-singular)와 diagonalizable은 매우 유사한 특성들을 가지나,

이들이 직접적으로 서로를 의미하는 건 아님에 유의할 것: invertible matrix가 diagnolizable을 보장하는 등의 관계는 없음.

자신의 column vector(or row vector)가 선형독립인 것과 eigen vector들이 선형독립인 것은 다른 애기임.

Matrix $A$ ($m>n$인 tall matrix)의 PCA(Principal Component Analysis)는

- $A^\top A$로 구한 covariance matrix를 Eigendecomposition 하여 구함:

- 이는 Symmetric Matrix인 $A^\top A$에 대한 Orthogonal Diagonalization임:

- $A^\top A$는 Positive Semi-Definite 인 특성이 추가됨(=항상 $A^\top A$의 eigenvalue가 non-negative가 된다.)

이는 달리 말하면 $A$에 대한 PCA는 Singular Value Decomposition 와 매우 밀접한 관계로 SVD의 결과(right singular matrix, $V$를 활용함.

- $A$의 SVD는 $A=U\Sigma V^\top$임.

- $A^\top A = V\Sigma^\top \Sigma V^\top$ 가 성립.

- $\Sigma^\top \Sigma$는 diagonal matrix이며, main diagonal은 모두 $A$의 singular value의 제곱임.

- $V$의 column은 모두 $A^\top A$의 eigen vector임이며 orthogonal matrix ($V^\top V=I$)임.

- 결국 PCA로 얻어진 principal component는 SVD의 right singular vecot $V$의 column임.

- Principal component의 variance는 singular value의 제곱임 ($A^\top A$의 eigenvalue = $A$의 singular value의 제곱).

2022.05.01 - [.../Math] - [Statistics] Covariance vs. Correlation

[Statistics] Covariance vs. Correlation

Covariance vs. CorrelationCovariance (공분산)"Covariance" is the raw version of correlation.두 random variable(확률변수)가 얼마나 (선형적으로) 같이 변하는 정도를 나타냄.여러 random variables 에서는 matrix로 기재

dsaint31.tistory.com

Orthogonal Diagonalization을 $A^\top A$ 에 대해 확장해서

$A$에 대해 적용한 Singular Value Decomposition (SVD) 가 가장 널리 사용되는 응용으로 대표적 사례는 다음과 같음.

- Dimensional Reduction: PCA의 구현.

- Image Compression

- Denoising

- Pseudoinverse $A^\dagger$ 계산 : Moore Penrose Pseudo Inverse

2024.02.15 - [.../Math] - [LA] Singular Value Decomposition (특이값분해, SVD)

[LA] Singular Value Decomposition (특이값분해, SVD)

Singular Value Decomposition$$A=U\Sigma V^\top$$Rank가 $n$인 matrix $A\in \mathbb{R}^{m\times n}\text{ where }m\ge n$ 에서orthonormal vector set$\{\textbf{v}_1, \dots, \textbf{v}_n\}, \{\textbf{u}_1, \dots \textbf{u}_n\}$ 와non-negative scalr set $\{\

dsaint31.tistory.com

The Spectral Theorem for Symmetric Matrices.

2024.07.20 - [.../Linear Algebra] - [LA] Spectral Theorem for Symmetric Matrix

[LA] Spectral Theorem for Symmetric Matrix

Symmetric Matrix(대칭 행렬)에 대한 Spectral Theorem은Symmetric Matrix에서 유용한 성질을 정리하고 있음.Spectral TheoremSymmetric Matrix를Eigen Vector $\mathbf{e}_i$ 각각의 Outer Product의 결과물인 Rank-1 Matrix ($=\mathbf{e}_1

dsaint31.tistory.com

$n \times n$ symmetric matrix $A$는 다음의 properties를 가짐.

- $\mathbf{A}$는 $n$개의 real eigenvalue (음수, 0, 양수 모두 가능)를 가짐.

- multplicity를 고려해서 세어야함.

- 특성방정식에서 중근인 eigenvalue는 2번 세고, 3중근이면 3번 세는 형태로

- symmetric matrix 중 $A^\top A , A^\top A$ 로 만들어진 경우엔 항상 0 이상의 real eigenvalue를 가짐: semi-positive definite.

- 각 eigenvalue들은 자신의 multiplicty에 해당하는 dimension의 eigne space를 가짐.

- 각각의 eigen space들은 서로 orthogonal임 (mutually orthogonal).

- $A$는 항상 $A=PDP^{\top}$을 만족하므로 orthogonally diagonalizable임.

- $\mathbf{D}$는 eigenvalue들을 main diagonal로 가지며,

- 이들 eigenvalue들을 spectrum of $\mathbf{A}$라고 부름.

Spectrum Theorem for the symmetric matrix 는

symmetric matrix (or Hermitian matrix)의 매우 유용한 property를 말해주며,

Fourier transform을 통한 spectrum analysis에 대한 선형대수적 기반을 애기해주고 있음.

단, orthogonally diagonalizable이어도 eigenvalue 중 0이 있을 수 있고,

이 경우 $\mathbf{A}$는 singular임.

Spectrum decomposition (or Spectral Decomposition)

symmetric matrix $\mathbf{A}$를 sum of rank 1 outer product of eigenvector로 나타낸 것.

Spectrum Decompositin은

Symmetric Matrix의 Eigenvalue Decomposition임.

$$ \begin{aligned}\mathbf{A}&=\mathbf{PDP}^\top \\ &=\begin{bmatrix}\textbf{u}_1 &\cdots&\textbf{u}_n\end{bmatrix}\begin{bmatrix}\lambda_1 & & 0 \\ & \ddots & \\ 0 & & \lambda_n\end{bmatrix}\begin{bmatrix}\textbf{u}_1^\top \\ \vdots \\ \textbf{u}_n^\top \end{bmatrix}\\ &=\begin{bmatrix} \lambda_1 \textbf{u}_1 & \cdots &\lambda_n \textbf{u}_n \end{bmatrix}\begin{bmatrix} \textbf{u}_1^\top \\ \vdots \\ \textbf{u}_n^\top \end{bmatrix} \\ &=\lambda_1\textbf{u}_1\textbf{u}_1^\top + \lambda_2\textbf{u}_2\textbf{u}_2^\top + \cdots +\lambda_n\textbf{u}_n\textbf{u}_n^\top \end{aligned} $$

- rank 1인 n개의 $n\times n$ matrix들의 합으로 분해한 것으로 각 eignevector에 대해 orthogonal projection의 linear combination으로 $\mathbf{A}$를 표현.

- $\textbf{u}_j\textbf{u}_j^\top$는 projection matrix로 $\textbf{u}_j$가 span하고 있는 subspace(, 여기선 $c\textbf{u}_j$로 표현되는 eigen space임)로의 orthogonal projection을 의미함.

참고 URL 및 더 살펴보면 좋은 URL

https://bme808.blogspot.com/2022/11/math-hermitian-symmetry.html

Math : Hermitian Symmetry

Hermitian symmetry는 complex function 또는 complex matrix에서의 대칭성 중 하나임. Hermitian Symmetry for Complex Function real number에서의 symm...

bme808.blogspot.com

2022.11.17 - [.../Math] - [LA] Normal Matrix (정규행렬)

[LA] Normal Matrix (정규행렬)

Normal Matrix란?Matrix $A \in M_n (C)$에 대해 (◀ Matrix가 Complex Number를 가질 수 있으며, $n\times n$ Square Matrix임), 다음을 만족하면 $A$를 Normal Matrix (정규행렬)이라고 부름.$$A{A^*}^\top(=AA^H)={A^*}^\top A(=A^H A)$$wh

dsaint31.tistory.com

2024.07.20 - [.../Linear Algebra] - [LA] Spectral Theorem for Symmetric Matrix

[LA] Spectral Theorem for Symmetric Matrix

Symmetric Matrix(대칭 행렬)에 대한 Spectral Theorem은Symmetric Matrix에서 유용한 성질을 정리하고 있음.Spectral TheoremSymmetric Matrix를Eigen Vector $\mathbf{e}_i$ 각각의 Outer Product의 결과물인 Rank-1 Matrix ($=\mathbf{e}_1

dsaint31.tistory.com

2025.01.21 - [.../Linear Algebra] - [Summary] Linear Algebra (작성중)

[Summary] Linear Algebra (작성중)

ML 을 위해 Linear Algebra 공부시 참고할만한 책더보기전체적으로 공부를 한다면 다음을 권함.Linear Algebra and Its Application, 5th ed 이상, David C. Lay5th ed. 는 웹에서 쉽게 pdf도 구할 수 있음.개인적으로 Str

dsaint31.tistory.com

'... > Linear Algebra' 카테고리의 다른 글

| [LA] Existence and Uniqueness Theorem (1) | 2024.02.17 |

|---|---|

| [LA] Linear Equation (선형 방정식) and Linear System 정리. (0) | 2024.02.16 |

| [LA] Affine Combination, Affine Hull and Affine Set (0) | 2024.02.16 |

| [LA] linear combination (1) | 2024.02.16 |

| [LA] Linear and Affine: Summary (1) | 2024.01.03 |