[LA] Inverse Matrix

·

.../Linear Algebra

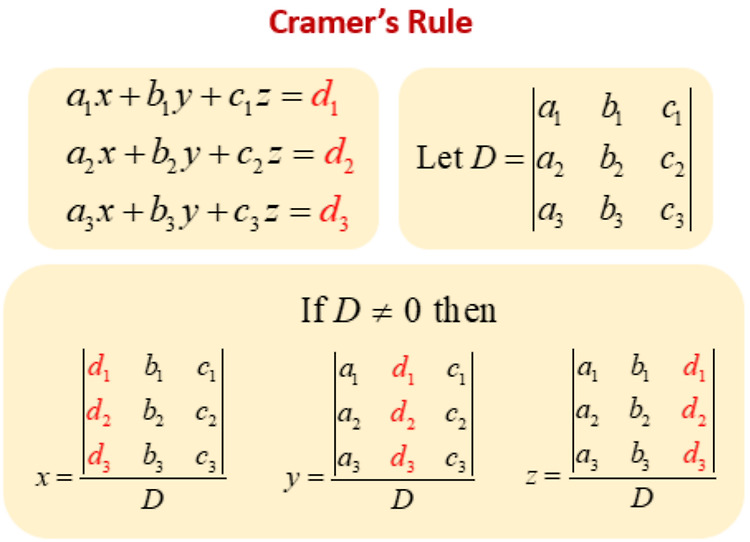

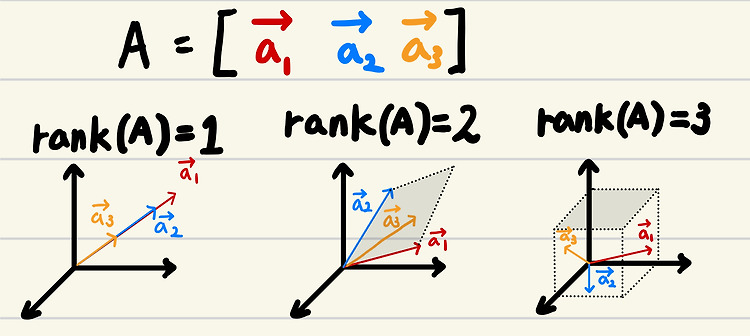

1. Inverse Matrix and Linear SystemLinear Algebra 의 가장 기본적인 응용은 Linear System (선형연립방정식)을 푸는 용도임.다음은 Linear System의 Matrix Equation임.Ax=b Inverse는 이 Linear System의 Solution x를 어찌보면 가장 기본적으로 푸는 방법이라고 볼 수 있음: $$\begin{aligned} A\mathbf{x} &= \mathbf{b} \\ A^{-1}A\mathbf{x} &= A^{-1}\mathbf{b} \\ I \mathbf{x} &= A^{-1}\mathbf{b} \\ \mathbf{x} &= A^{-1}\mathbf{b} \end..