[Math] Derivative of Logistic Function

·

.../Math

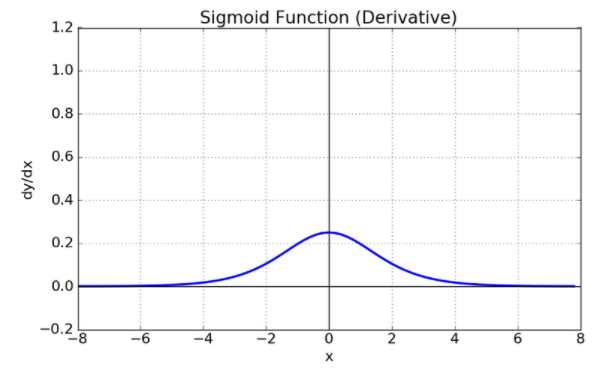

Derivative (도함수) of Logistic Function (Sigmoid라고도 불림) y=σ(x)=11+e−x 를 미분하면 다음과 같음. ddxσ(x)=σ(x)(1−σ(x)) graph 유도 유도는 다음과 같음. $$\begin{aligned}\frac{d}{dx}\sigma(x)&= \dfrac{0\times(1+e^{-1}) - 1\times(-e^{-1})}{(1+e^{-x})^2}\\&=\dfrac{e^{-x}}{(1+e^{-x})^2}\\ &= \frac{1}{(1+e^{-x})}\frac{e^{-x}}{(1+e^{-x})}\\ &= \frac{1}{(1+e^{-x})}\left( 1-\dfrac{..